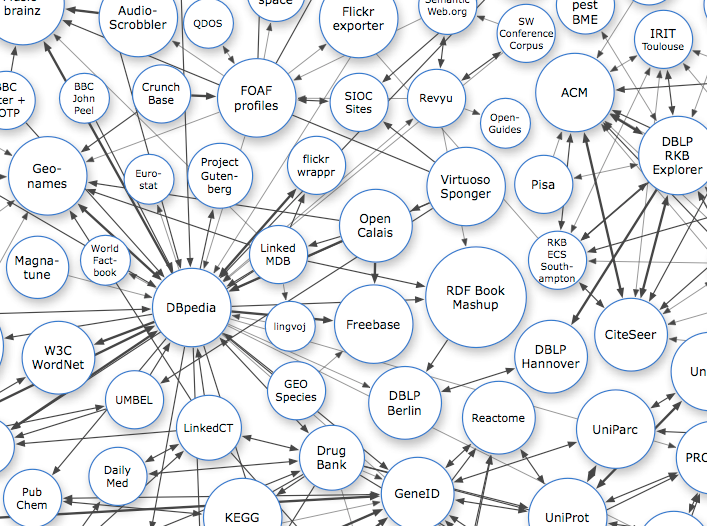

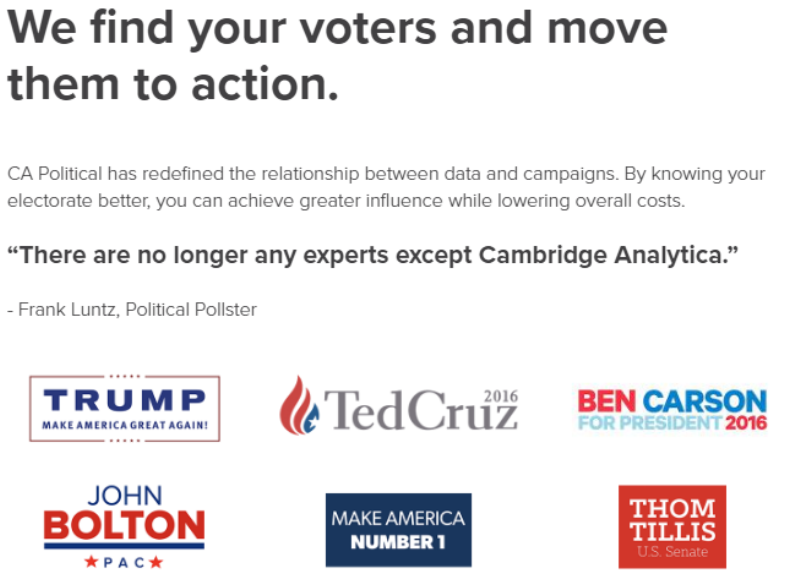

class: center, middle background-image: url(./img/seurat.jpg) background-size: cover background-position: 50% 50% # De l'open data au big data ## Culture générale des données <BR><BR><BR> ## Samuel Goëta et Joël Gombin (Datactivist) ### Paris, 29 et 30 janvier 2018 --- class: center, middle Ces slides en ligne : https://datactivist.coop/dataliteracy/ Sources : https://github.com/datactivist/dataliteracy [Notes collaboratives](https://paper.dropbox.com/doc/Formation-Culture-Generale-des-Donnees-XjrveJ0tbnwsdhbOYLd8D?_tk=share_copylink) Les productions de Datactivist sont librement réutilisables selon les termes de la licence [Creative Commons 4.0 BY-SA](https://creativecommons.org/licenses/by-sa/4.0/legalcode.fr). <img src="./img/Logo_DATACTIVIST_TW.png" height="150px" /> --- class: middle, center # Jour 1 : # comprendre l’écosystème des données --- class:middle # Programme de la matinée Workshop 1 — Qu’est ce qu’une donnée ? Exercice d’identification, définition et étymologie du terme Petite histoire sociale des données et de leur exploitation Datafication : les promesses de la mise en données du monde Données, données… quelles données ? Quantitatives, qualitatives, structurées, non structurées, capturées, échappées, dérivées… Open data, big data, linked data, data API : les habits neufs de la donnée --- class:middle # Programme de l'après-midi Poursuite de "Open data, big data, linked data, data API : les habits neufs de la donnée " Cadre juridique et protection de la vie privée Modèles économiques de l’open data et du big data Workshop 3 — analyse du modèle économique d’entreprises de la data --- class:middle, center ## Echauffement : 5 minutes, 20 données Vous avez 5 minutes Vous devez trouver 20 données dans notre environnement immédiat Pas de recours aux écrans ! .footnote[[source](http://infolabs.io/5-minutes-20-donnees)] --- class:center,inverse, middle # Qu'est-ce qu'une donnée ? --- class:center,inverse, middle #D'après vous ? --- # Le censeur à Rome, ancêtre de la statistique .reduite3[] .footnote[Source : *Asterix chez les pictes*, © Albert René 2013] --- # Le censeur à Rome, ancêtre de la statistique .reduite3[] .footnote[*Asterix chez les pictes*, © Albert René 2013] --- ## La statistique : outil de gouvernement et de preuve .pull-left[.middle[La statistique est à la fois : + **outil de gouvernement** (_Statistik_ - 18e siècle), et + **outil de preuve** (_statistics_ - 19e siècle)]] .pull-right[] --- ## [Quantifier, c'est convenir puis mesurer](http://www.pressesdesmines.com/media/extrait/PourSocioHistExtr.pdf) .pull-left[ > Le verbe quantifier est employé ici dans un sens large : **exprimer et faire exister sous une forme numérique ce qui, auparavant, était exprimé par des mots et non par des nombres**.] .pull-right[] --- ## [Quantifier, c'est convenir puis mesurer](http://www.pressesdesmines.com/media/extrait/PourSocioHistExtr.pdf) .middle.reduite3[  ] .footnote[*Asterix chez les pictes*, © Albert René 2013] --- ## Quantifier, c'est inscrire et figer une réalité sans cesse mouvante .reduite2[] .footnote[*Asterix chez les pictes*, © Albert René 2013] --- ## Etymologie ### Latin : _dare_ (donner) > _datum_ (donné) > _data_ (donnés) <br/><br/> Ce qui est évident, va de soi, est accepté sans discussion <br/><br/> > From its first vernacular formulation, the existence of a datum has been independent of any consideration of corresponding ontological truth. When a fact is proven false, it ceases to be a fact. False data is data nonetheless. .footnote[[Rosenberg, 2013](https://mitpress.mit.edu/books/raw-data-oxymoron)] --- class:middle ## Usage de "data" .pull-left[ Le sens moderne apparaît à la fin du 18e siècle. Renvoie à des expériences, des collectes d'éléments.] .pull-right[] --- # “Datafication” : la mise en données du monde > “L'immense gisement de données numériques découle de la capacité à paramétrer des aspects du monde et de la vie humaine qui n'avaient encore jamais été quantifiés. On peut qualifier ce processus de **« mise en données » (datafication)**. > […] “La mise en données désigne autre chose que la numérisation, laquelle consiste à traduire un contenu analogique - texte, film, photographie - en une séquence de 1 et de 0 lisible par un ordinateur. Elle se réfère à une action bien plus vaste, et aux implications encore insoupçonnées : **numériser non plus des documents, mais tous les aspects de la vie**.” .footnote[[Kenneth Cukier, “Mise en données du monde, le déluge numérique”](https://www.monde-diplomatique.fr/2013/07/CUKIER/49318)] --- # “Datafication” : la mise en données du monde > “L'immense gisement de données numériques découle de la capacité à paramétrer des aspects du monde et de la vie humaine qui n'avaient encore jamais été quantifiés. On peut qualifier ce processus de **« mise en données » (datafication)**. > […] “La mise en données désigne autre chose que la numérisation, laquelle consiste à traduire un contenu analogique - texte, film, photographie - en une séquence de 1 et de 0 lisible par un ordinateur. Elle se réfère à une action bien plus vaste, et aux implications encore insoupçonnées : **numériser non plus des documents, mais tous les aspects de la vie**.” .footnote[[Kenneth Cukier, “Mise en données du monde, le déluge numérique”](https://www.monde-diplomatique.fr/2013/07/CUKIER/49318)] --- # La "nombrification" du monde .pull-left[] .pull-right[ > La numérisation ne serait pas survenue sans une "nombrification" préalable qui consiste à quantifier de plus en plus d'aspects de notre expérience du réel. > **Au commencement était le verbe, il semble à la fin que tout devient nombre.** > Personne ne saurait parler sérieusement de l'état de la société et discuter politique sans se référer aux informations quantitatives. ] --- class:middle # Le nouveau positivisme des données > *If you asked me to describe the rising philosophy of the day, I’d say it is **data-ism**. We now have the ability to gather huge amounts of data. This ability seems to carry with it certain cultural assumptions — that everything that can be measured should be measured; that data is a transparent and reliable lens that allows us to filter out emotionalism and ideology; that data will help us do remarkable things — like foretell the future.* Jeff Brookes, éditorialiste du New York Times --- ## Aux sources de la mise en données du monde .pull-left[ - Rencontre, dans la Californie des années 1960, entre la Nouvelle Gauche et les Nouveaux Communalistes sur fond de LSD et de recherche militaire - L'inspiration de la cybernétique (N. Wiener) : objets techniques et êtres humains constituent un même système sociotechhnique, régulé par l'information - Exemple de Steward Brand, fondateur du _Whole Earth Catalog_ puis de Wired => ["Forest Gump de l'Internet"](https://questionsdecommunication.revues.org/8619)] .pull-right[ ] --- ## "Raw data" is an oxymoron .pull-left[ > Data are always already “cooked” and never entirely “raw.” > Data need to be imagined _as_ data to exist and function as such, and the imagination of data entails an interpretive base.] .pull-right[ ] .footnote[[Source](https://mitpress.mit.edu/books/raw-data-oxymoron)] --- class:inverse, middle, center # Vers une définition des données --- ## La pyramide Data-Information-Knowledge-Wisdom .pull-left[ [](https://commons.wikimedia.org/w/index.php?curid=37705247) ] .pull-right[Attribuée à [Russell Ackoff](http://en.wikipedia.org/wiki/Russell_L._Ackoff), 1989 Les données peuvent être des : - faits - signal/stimulis - symboles] --- # Vers une définition des données .pull-left.reduite2[  ] .pull-right[ > *Data are commonly understood to be the raw material produced by **abstracting the world** into categories, measures and other representational forms – numbers, characters, symbols, images,sounds, electromagnetic waves, bits – that constitute the **building blocks** from which information and knowledge are created.* ⏺ enregistrabilité 🏗> briques de base ("*buildings blocks*")] --- class:middle # Data or capta ? > *Technically, then, what we understand as data are actually **capta** (derived from the Latin capere, meaning ‘to take’); those units of data that have been selected and harvested from the sum of all potential data.* [Kitchin, 2014](https://books.google.fr/books?hl=fr&lr=&id=GfOICwAAQBAJ&oi=fnd&pg=PP1&dq=kitchin+data+revolution&ots=pcyfMTZh-V&sig=dQyPTL3AIN_4RdWvtBFw4VjdAa4#v=onepage&q=kitchin%20data%20revolution&f=false) --- class:middle # Données ou obtenues ? > « Décidément, on ne devrait jamais parler de “données”, mais toujours d’ “obtenues”. » Bruno Latour, 1993 --- class:center, middle, inverse # Données, données... quelles données ? --- ## Données quantitatives .pull-left[ Différents types de variables : - nominale : des catégories que l’on nomme avec un nom (marié/célibataire/divorcé/veuf) - ordinale : échelle de mesure dotant chaque élément d'une valeur qui permet leur classement par ordre de grandeur (faible, moyen, fort) - intervalles : l’intervalle entre deux catégories à toujours la même valeur (12-16°C / 16-20°C / 20-24 °C …) ] .pull-right[  ] --- # Données qualitatives .pull-left[ Non numérique => texte, image, vidéo, son, musique... + peut être convertie en données quantitatives + risque de perdre la richesse des données originales + analyse qualitative de données ] .pull-right[  ] --- # Exemple : les annotations en text mining .reduite[] --- ## Données structurées .pull-left[ Des données dotées d'un modèle qui définit les relations entre les composantes de la base de données + Ex : base de données relationnelle SQL + Lisibles machine + Faciles à analyser, manipuler, visualiser... ] .pull-right[  ] --- # Données semi-structurées .pull-left[ Pas de modèle prédéfini : structure irrégulière, implicite... mais données organisées néanmoins, ensemble raisonnable de champs Exemple : XML, JSON Possible de trier, ordonner et structurer les données ] .pull-right[  ] --- # Données non structurées .pull-left[Pas de structure commune identifiable Exemple : BDD NoSQL Généralement qualitatives Difficilement combinées ou analysées quantitativement Les données non structurées croitraient 15x plus que les données structurées Machine learning de + en + capable d'analyser ces données.] .pull-right[  ] --- # Données capturées, échappées, transitoires ** Données capturées** Observation, enquête, expérimentation, prise de notes, senseurs... => intention de générer des données ** Données échappées** Sous-produit d'un engin ou d'un système dont la fonction première est autre ** Données transitoires** Echappées qui ne sont jamais examinées, transformées ou analysées --- ## Données dérivées Résultat d'un traitement ou une analyse supplémentaire de données capturées. Exemple avec les [données de Google Maps](https://www.justinobeirne.com/google-maps-moat) :  --- ## Données dérivées .reduite2[] --- ##Index, attributs, métadonnées **index** Des données permettent l'identification et la mise en relation. Essentiels pour enrichir les données **Attributs** Des données représentent les aspects d'un phénomène, mais ne sont pas des index (pas identifiants uniques) **Métadonnées** Des données sur les données. Peuvent être descriptives, structurelles ou administratives. Standard : Dublin Core. --- #Les données crowdsourcées .pull-left[Des données produites par des citoyens, des communs partagés et gouvernés par leurs producteurs Exemple : OpenStreetMap, le wiki de la carte] .pull-right[ .reduite[] ] --- class:inverse, middle, center # De l'open data au big data --- ## Open data : quelques jalons historiques  --- # 07 Décembre 2007 : la rencontre de Sebastopol .pull-left[ 👥 **Quoi ?** Une rencontre de l'Open Governement Group à Sebastopol (Californie), siège des éditions O'Reilly 🎯 **Pourquoi ?** : Influencer le futur président des Etats Unis pour faire avancer l'open data 📜 **Comment ?** En adoptant une déclaration définissant les grands principes de l'Open Government Data ] .pull-right[  ] --- class:middle, center  # Revue des principes --- class: middle, center # 1. Des données complètes ### Toutes les données publiques doivent être rendues disponibles dans les limites légales liées à la vie privée ou la sécurité --- class: center, middle  # BY DEFAULT --- class: middle, center # 2. Des données primaires ### Les données ouvertes sont telles que collectées à la source, non-agrégées avec le plus haut niveau de granularité --- class: middle, center # 3. Des données fraiches (*timely*) ### Les données doivent être disponibles dès qu'elles sont produites --- class: middle, center # 4. Des données accessibles ### Les données doivent être utilisables par le plus grand nombre d’usagers potentiels --- class: middle, center # 5. Des données exploitables par les machines ### Les données peuvent être traitées automatiquement par les machines --- class: middle, center # 6.Des données non discriminatoires ### Elles peuvent être utilisées par tous sans réclamer un enregistrement préalable --- class: middle, center # 7. Des données dans un format ouvert ### Ce format ne doit pas être la propriété d'une organisation en particulier (.xls) et doit être gouvernée par ses usagers --- class: middle, center # 8. Des données dans une licence ouverte ### Idéalement dans le domaine public sinon dans une licence conforme à l'[Open Definition](www.opendefinition.org) : Licence Ouverte (CC-BY) ou ODBL (CC-BY-SA) --- # Défi 1 : la découvrabilité des données .pull-left[ > Data findability is a major challenge. We have data portals and registries, but government agencies under one national government still publish data in different ways and different locations.(…) **Data findability is a prerequisite for open data to fulfill its potential and currently most data is very hard to find.** ] .pull-right[  .footnote[https://index.okfn.org/insights/] ] --- class:middle, center  --- # Défi 2 : le problème de la qualité .pull-left[ >**Government data is usually incomplete, out of date, of low quality, and fragmented.** In most cases, open data catalogues or portals are manually fed as the result of informal data management approaches. **Procedures, timelines, and responsibilities are frequently unclear among government institutions tasked with this work.** .footnote[http://opendatabarometer.org/4thedition/report/] ] .pull-right[  ] --- ## Exemple de données ouvertes : la base SIRENE .reduite2[] --- #La base SIRENE : exemple de cas d'utilisation .reduite[.center[]] --- ##Exemple de données ouvertes : la base adresses .reduite[.center[]] --- ##Exemple de données ouvertes : les accidents de la route .reduite[.center[]] --- #Les accidents de la route .reduite2[.center[]] .footnote[Plus d'accidents sur l'A8 mais surtout plus de véhicules…] --- #Les accidents de la route .reduite2[.center[]] .footnote[[Carte par Joël Gombin dans Marsactu](https://joelgombin.github.io/marsactu_accidents/chronique.html)] --- ## Exemple de données ouvertes : les inspections des restaurants .reduite2[.center[]] .footnote[[Résultats des contrôles officiels sanitaires : dispositif d'information « Alim’confiance »](https://www.data.gouv.fr/fr/datasets/resultats-des-controles-officiels-sanitaires-dispositif-dinformation-alimconfiance/)] --- #Les inspections des restaurants .reduite2[.center[]] .footnote[[26 établissements au niveau d'hygiène à corriger de manière urgent ](https://dgal.opendatasoft.com/explore/embed/dataset/export_alimconfiance/map/?disjunctive.app_libelle_activite_etablissement&disjunctive.filtre&refine.synthese_eval_sanit=A%20corriger%20de%20mani%C3%A8re%20urgente&location=6,47.24195,5.00977&static=false&datasetcard=true)] --- ## Big data  --- # L'obsession du volume de données .pull-left[ **Quelques chiffres omniprésents** : - le volume de données produit double tous les 3 ans (Gantz & Reisel 2011) - 90% des données créées dans les deux dernières années (IBM 2012) - 40% : croissance annuelle de la production de données (Maniyka et al. 2011) **Problèmes de cette approche** : - Estimations guidées par des intérêts commerciaux - Ne définit pas ce que sont ces données - Résume le big data au Volume -Explique mal la mise en données du monde ] .pull-right[  ] --- # Les promesses du big data Kitchin (2014) résume les promesses du big data : - **“Governing people”** : dans la continuité de la statistique, améliorer la connaissance de l’administration et prédire les crimes - **“Managing organisations”** : améliorer le fonctionnement de toutes les composantes de l’organisation par l’exploitation des données - **“Leveraging value and producing capital”** : micro-ciblage marketing, optimisation des magasins et des opérations, efficience de la chaine - **“Creating Better places”** : gouverner les villes avec des données (smart city) - **Un nouveau paradigme scientifique** : une nouvelle ère guidée par les corrélations --- ## Linked data .pull-left[ - poussé par W3C et Tim Berners-Lee - - eb sémantique / web des données - RDF / SPARQL - wikidata => http://projetjourdain.org/network/index.html] .pull-right[  ] --- [](http://histropedia.com/timeline/3jrttpg9bg0t/Google) --- ## API .pull-left[ - Application programming interface => un programme vu de la surface - les machines parlent aux machines - donnée dynamique => ouverture potentiellement limitée et contrôlée - un exemple : [overpass turbo](https://overpass-turbo.eu/)] .pull-right[  ] --- class:inverse, middle, center # Cadre juridique et protection de la vie privée ### Focus sur le RGPD --- # Répondre à la faiblesse du cadre juridique existant .center.reduite2[  ] --- # Le RGPD ? **Réglement Général de Protection des Données** : adopté à la mi-avril 2016 après 4 années de débat, il va considérablement renforcer le droit européen de protection des données personelles 3 objectifs : - Renforcer les droits des personnes - Responsabiliser les acteurs traitant des données personnelles - Crédibiliser la régulation Le RGPD propose un **cadre unifié pour l'ensemble de l'UE** qui s'applique à chaque fois qu'un résident européen est visé par un traitement de données personnelles. --- # Renforcer les droits des personnes .pull-left[  **Droit à la portabilité des données** : Droit de recevoir ses données "dans un format structuré, couramment utilisé et lisible par machine" et de les transmettre à un autre service si possible de matière automatisée ] .pull-right[  **Transparence et consentement explicite** : plus de lisibilité sur ce qui est fait de mes données (preuve de consentement explicite dans des termes clairs) et j’exerce mes droits plus facilement (droit d’accès, droit de rectification, droit à l'oubli). ] .footnote[Source : [CNIL](https://www.cnil.fr/fr/plus-de-droits-pour-vos-donnees)] --- ## Exemple de demande de consentement explicite .center.reduite2[  ] --- # Renforcer les droits des personnes .pull-left[  **Protection des mineurs** : Les services en ligne doivent obtenir le consentement des parents des mineurs de moins de 16 ans avant leur inscription. ] .pull-right[  **Guichet unique** : En cas de problème, je m’adresse à l’autorité de protection des données de mon pays, quelque soit le lieu d’implantation de l’entreprise qui traite mes données. ] .footnote[Source : [CNIL](https://www.cnil.fr/fr/plus-de-droits-pour-vos-donnees)] --- # Renforcer les droits des personnes .pull-left[  **Sanctions renforcées** : En cas de violation de mes droits, l’entreprise responsable encourt une sanction pouvant s’élever à 4% de son chiffre d’affaires mondial. ] .pull-right[  **Droit à l'oubli** : Je peux demander à ce qu’un lien soit déréférencé d’un moteur de recherche ou qu’une information soit supprimée s’ils portent atteinte à ma vie privée. ] .footnote[Source : [CNIL](https://www.cnil.fr/fr/plus-de-droits-pour-vos-donnees)] --- ## Responsabiliser les acteurs traitant des données personnelles .pull-left[ Principes : - **Privacy by design** : protection des données personnelles dès la conception du produit et par défaut - **Minimisation** : limiter la quantité de données personnelles dès le départ - **Accountability** : mettre en place des mesures de protection des données et démontrer cette conformité à tout moment - Fin des obligations déclaratives sauf si risque accru pour la vie privée ] .pull-right[  ] --- # Les 6 étapes de la mise en conformité .pull-left[  ] .pull-right[ 1. **Désigner un pilote** : Délégué à la Protection des Données (Data Protection Officer) exerce une mission d’information, de conseil et de contrôle en interne. 2. **Cartographier** : élaboration d'un registre des traitements des données personelles 3. **Prioriser** : sur la base du registre, identifiez les actions à mener en priorité pour se conformer aux obligations actuelles et à venir. ] .footnote[ℹ DPO obligatoire uniquement pour secteur public et entreprises dont le traitement de données sensibles à grande échelle est une activité principale. ] --- # Les 6 étapes de la mise en conformité .pull-left[ 4.**Gérer les risques** : Si identification de risques élevés, mener pour chaque traitement concerné une analyse d'impact sur la protection des données (PIA). 5.**S'organiser** : mise en place de procédures pour l’ensemble des événements qui peuvent survenir au cours de la vie d’un traitement (ex : faille de sécurité, demande de rectification, changement de prestataire…) 6.**Documenter** : prouver votre conformité au règlement, constituer et regrouper la documentation nécessaire qui doit être réexaminée régulièrement. ] .pull-right[  ] --- # Crédibiliser la régulation ⚖️ Les autorités de protection peuvent notamment : limiter temporairement ou définitivement un traitement, suspendre les flux de données, ordonner la rectification, la limitation ou l'effacement des données… 🔫 Amendes : jusqu'à 10 ou 20 millions d’euros, ou, dans le cas d’une entreprise, de **2% jusqu’à 4% du chiffre d'affaires annuel mondial**, le montant le plus élevé étant retenu. 🇪🇺 Sanction sera **conjointement adoptée entre l’ensemble des autorités concernées**, donc potentiellement pour le territoire de toute l’Union européenne. --- class:inverse, middle, center # Modèles économiques de l'open data et du big data --- # Les 3 facettes de la valeur des données .pull-left[ - La donnée comme **matière première** : revendue par celui qui la collecte ou l’agrège - la donnée comme **levier** : utilisée sans marchandisation, par exemple pour réduire les coûts ou développer les revenus - la donnée comme **actif stratégique** : une arme pour prendre pied sur un marché, ou défendre son positionnement] .pull-right[.reduite2[]] --- ## Les data brokers : la vie privée comme matière première - 👻 Des entreprises inconnues du grand public : **Acxiom, Epsilon, Experian** - 💰 Un marché estimé par le Congrès américain à 156 milliards de dollars en 2012 - 🕵 "Data brokers are worse than the NSA" (Sénateur Rockefeller) : aucune transparence ni véritable régulation aux US - 🔍 En moyenne, 200 points de données sur chaque individu aux Etats Unis. Plus de 50 000 sources. - 🚰 Sources : données publiques (permis de construire, registres des naissances, casiers judiciaires…), cookies, données d'achat, cartes de fidélité, données téléphoniques, recherches en ligne… --- # Une dépossession de la vie privée .pull-left[ > "*Data brokers take public and private information, aggregate it into products and monetize it. *[…] > *"Through the combination of data possession and innovation, data brokers **claim ownership of our data.**"* ] .pull-right[ .reduite2[] ] --- # La donnée comme levier .pull-left[- Utiliser les données **pour son propre compte** sans monétisation directe auprès d'un tiers - Données : leviers pour mieux allouer ressources ou développer le résultat - Possibilité de compléter ou développer le modèle d'affaires] .pull-right[  ] --- # La donnée comme actif stratégique .pull-left[ Utiliser des données pour soutenir un modèle économique, acquérir ou défendre une position au sein d'un écosystème ] .pull-right[  ] --- class:inverse, middle, center # Analyse de modèle économiques d'entreprises de la data --- # Lisons cet article de Wired sur Foursquare [.reduite2[]](https://www.wired.com/2016/01/foursquares-plan-to-use-your-data-to-make-money-even-if-you-arent-a-user/) --- ## Remplissons ensemble le business model canvas .reduite2[ [](https://frama.link/bmcanvas) ] https://frama.link/bmcanvas --- class:inverse, middle, center # Merci ! ## Evaluation de la journée --- class: middle, center # Jour 2 : # ouvrir la boite noire de la data science --- class:middle # Programme de la matinée - Qu'est-ce que la data science ? - Workshop 4 : quelles compétences recruter dans un projet de data science ? - Le data pipeline : acquérir les données, les vérifier, les nettoyer, les analyser, les présenter --- class:middle # Programme de l'après midi - Workshop 5 : data visualisation : quel format et quel outil choisir pour quelle fonction ? - Modéliser pour prédire : introduction au machine learning et deep learning - Workshop 6 : décortiquons quelques algorithmes notoires --- class: middle, center, inverse # Qu'est-ce que la data science ? --- ## Au commencement était la statistique - une vieille science (18e siècle), pour aider les États (_Statistik_) mais aussi des entreprises privées (au départ, les assureurs => actuariat) - fondée sur les probabilités - faite par des mathématiciens - forte dimension théorique --- ## Au commencement était la statistique <iframe src="http://giphy.coms/embed/9ADoZQgs0tyww" width="100%" height="450" frameBorder="0" class="giphy-embed" allowFullScreen></iframe><p><a href="http://giphy.com/gifs/obama-awesome-statistics-9ADoZQgs0tyww">via GIPHY</a></p> --- ## Au commencement était la statistique > I keep saying the sexy job in the next ten years will be statisticians. People think I’m joking, but who would’ve guessed that computer engineers would’ve been the sexy job of the 1990s? Hal Varian (Chief economist, Google), _The McKinsey Quarterly_, January 2009 --- ## Data science is the new statistics? > “I think data-scientist is a sexed up term for a statistician” [Nate Silver](http://www.statisticsviews.com/details/feature/5133141/Nate-Silver-What-I-need-from-statisticians.html) --- ## Data science is the new statistics? [.reduite[.center[]]](http://www.prooffreader.com/2016/09/battle-of-data-science-venn-diagrams.html) --- ## Le rôle de l'informatique - statistique classique : les problèmes doivent pouvoir être résolus de manière analytique (d'où le succès du [fréquentisme](https://fr.wikipedia.org/wiki/Interpr%C3%A9tations_de_la_probabilit%C3%A9#Fr%C3%A9quentisme)) - le développement de la puissance de calcul permet de résoudre des problèmes statistiques par la simulation ([MCMC](https://fr.wikipedia.org/wiki/M%C3%A9thode_de_Monte-Carlo_par_cha%C3%AEnes_de_Markov)) --- ## Développement de la puissance de calcul [.reduite[.center[]]](http://visual.ly/infographic-about-computers) --- ## Développement de la capacité de stockage [.reduite[.center[]]](https://twitter.com/alicemazzy/status/655306196128280576?ref_src=twsrc%5Etfw) --- ## Développement de la capacité de stockage [.reduite[.center[]]](https://aws.amazon.com/blogs/aws/aws-snowmobile-move-exabytes-of-data-to-the-cloud-in-weeks/) --- ## Développement de la capacité de stockage [.reduite[.center[]]](https://aws.amazon.com/blogs/aws/aws-snowmobile-move-exabytes-of-data-to-the-cloud-in-weeks/) ??? Jusqu'à 100 Po par camion. 1 Po = 1000 To --- ## Développement de la capacité de stockage [.reduite[.center[]]](https://aws.amazon.com/blogs/aws/aws-snowmobile-move-exabytes-of-data-to-the-cloud-in-weeks/) --- ## La simulation, méthode reine d'estimation statistique Monte Carlo Markov Chain (MCMC) : papier de Metropolis et Ulam (1949) http://chifeng.scripts.mit.edu/stuff/mcmc-demo/#HamiltonianMC,banana --- class:inverse, center, middle # Analyse, modélisation, machine learning --- ## Que fait-on une fois qu'on a des données ? - Exploratory Data Analysis (Tukey, 1977) : pas d'hypothèse préalable à tester, plutôt pour générer des hypothèses. Rôle de la datavisualisation - test d'hypothèse --- ## Que fait-on une fois qu'on a des données ? .reduite[.center[]] --- ## Que fait-on une fois qu'on a des données ? - Exploratory Data Analysis (Tukey, 1977) : pas d'hypothèse préalable à tester, plutôt pour générer des hypothèses. Rôle de la datavisualisation - test d'hypothèse - **modèle** --- class: inverse, center, middle # Workshop 4 : quelles compétences recruter dans un projet de data science ? --- class: center, middle  (source : http://fing.org/?Les-competences-Data) --- class: center, middle  --- class: center, middle  --- class: center, middle  --- class: center, middle  --- class: center, middle À vous : de quelles compétences data avez-vous besoin pour votre projet data ? --- class: center, middle, inverse # L'écosystème de la data science --- ## Bases de données Marché de ~ 25 milliards de $ Oracle, Microsoft... MySQL, PostgreSQL, SQLite... DB orientées colonnes : MonetDB... NoSQL : MangoDB, CouchDB, BigTable (Google), Neo4j, Redis... --- ## Bases de données distribuées Hadoop / Cloudera => MapReduce et HDFS --- ## Hadoop [](https://www.chrisstucchio.com/blog/2013/hadoop_hatred.html) Voir aussi http://ismydatabig.com/ --- ## Hadoop / MapReduce Permet une réelle scalabilité (ajoutons des nœuds), MAIS contraint fortement les algorithmes pouvant être utilisés, qui doivent être parallélisables. Ex : ACP => c'est compliqué --- ## Spark Principe similaire à Hadoop, mais travaille en mémoire vive de manière non séquentielle De 10 à 100x plus rapide que Hadoop --- ## Langages - Java - Python - R - Scala - Julia - SQL - C / C++ - ... --- ## Une carte interactive http://xyz.insightdataengineering.com/blog/pipeline_map.html --- class: center, middle, inverse # Le data pipeline --- .reduite[.center[]] --- ## Définir les données dont on a besoin .center[] --- ## Trouver les données dont on a besoin .center[] ??? Où cherchez-vous vos données ? - dépôts internes - CDO - dépôts externes - data brokers - etc. --- ## Acquérir les données .center[] ??? Connecteurs ETL : ex Talend, Logstash --- ## Vérifier les données .center[] ??? Importance d'un sanity check --- ## Vérifier les données .center[[](http://www.erogol.com/ml-work-flow-part-4-sanity-checks-data-spliting/)] --- ## Nettoyer les données .center[] ??? Paradigme du *tidy data* --- ## Analyser les données .center[] --- ## Communiquer les résultats .center[] ??? dataviz reproducible research appli dashboard etc. --- class: inverse, center, middle # Workshop 5 : Introduction à la data visualisation [datactivist.coop/odl_paca](https://datactivist.coop/odl_paca) --- ## Pourquoi modéliser ? .reduite[.center[]] --- ## Pourquoi modéliser ? Les ["deux cultures"](https://projecteuclid.org/download/pdf_1/euclid.ss/1009213726) - pour analyser et expliquer - pour prédire --- ## Pourquoi modéliser ? Les ["deux cultures"](https://projecteuclid.org/download/pdf_1/euclid.ss/1009213726) - pour analyser et expliquer (**statistiques classiques, économétrie**) - pour prédire (**machine learning, IA...**) --- ## Modéliser pour analyser - un modèle réduit de la réalité - isoler le rôle de chaque variable - raisonner "toutes choses égales par ailleurs" (*ceteris paribus*) --- ## Modéliser pour analyser Modéliser, c’est mettre en relation une *variable expliquée* (dépendante / prédite) et une ou plusieurs *variables explicatives* (indépendantes / prédicteurs). $$ Y = f(X_1, X_2, X_3, ..., X_n) $$ L’estimation du modèle consiste à estimer la valeur des paramètres (ou coefficients). Le cas du modèle linéaire : $$ Y = α + β_1X_1 + β_2X_2 + β_3X_3 + · · · + β_nX_n + ε $$ --- ## Modéliser pour analyser Implique de faire des hypothèses sur la spécification du modèle : - variables explicatives - distribution des erreurs --- ## Les distributions - distribution théorique (ex : distribution normale) - distribution empirique http://shiny.stat.calpoly.edu/Prob_View/ --- ## All models are wrong, some are useful > Since all models are wrong the scientist cannot obtain a "correct" one by excessive elaboration. On the contrary following William of Occam he should seek an economical description of natural phenomena. [George Box](https://dx.doi.org/10.1080%2F01621459.1976.10480949) --- ## All models are wrong, some are useful .reduite[.center[]] --- ## Estimation d'un modèle Dans le cas d'un modèle linéaire => méthode des moindres carrés ordinaires (MCO/OLS) http://setosa.io/ev/ordinary-least-squares-regression/ --- ## Attention ! - Les modèles de régression linéaire supposent que les relations sont *linéaires* et *additives*. - Les *résidus* sont supposés être *normalement distribués*. - Les coefficients ne sont *pas standardisés* (on ne peut pas les comparer entre eux). - Les coefficients s’interprètent *relativement à l’unité de la variable dépendante*. --- ## Attention ! - Les coefficients estiment l’effet d’une variable indépendante sur la variable dépendante *toutes choses égales par ailleurs*, c’est-à-dire en neutralisant l’effet des autres variables. - La qualité globale du modèle peut être quantifié au travers du `\(R^2\)`, qui représente la part de variance (de la variable dépendante) expliquée. - Pour les variables indépendantes catégoriques, on estime un coefficient par modalité, à l’exception de la première (baseline). --- ## Modèles statistiques Compromis entre intelligibilité et fidélité aux données --- ## Underfitting et overfitting .reduite[.center[]] --- ## Underfitting et overfitting - différencier données d'apprentissage et données de test - n'utiliser les données de confirmation (test) qu'une fois --- ## Extrapolation [.reduite[.center[]]](http://r4ds.had.co.nz/model-basics.html) --- ## Et le machine learning alors ? - Fondamentalement, modélisation et machine learning ne sont pas différents, du point de vue d'un statisticien : modéliser un `\(Y\)` en fonction d'un vecteur de `\(X_i\)` - une des différences principales toutefois : veut-on prévoir ou comprendre/analyser ? - et donc : peut-on, veut-on interpréter les coefficients ? - en pratique : machine learning porte généralement sur des données plus complexes que la modélisation traditionnelle - souvent beaucoup de valeurs manquantes --- ## Et le machine learning alors ? .reduite[.center[]] --- ## Concepts de machine learning - Apprentissage supervisé vs non supervisé - Apprentissage supervisé : il faut des données déjà classées/étalonnées. Souvent à la main ! => *#digitallabour* --- ## Apprentissage supervisé [.reduite[.center[]]](https://fakecaptcha.com) --- ## Apprentissage supervisé [.reduite[.center[]]](https://cquest.hackpad.com/OpenSolarMap-9oMiYswLksF) --- ## Apprentissage supervisé [.reduite[.center[]]](https://static.googleusercontent.com/media/research.google.com/en//pubs/archive/36955.pdf) --- ## Apprentissage non supervisé - problème majeur : réduction de la dimensionnalité - jeux de données à très haute dimensionnalité : impossible à explorer visuellement. Comment simplifier l'information et la résumer ? .reduite[.center[]] --- ## Apprentissage non supervisé https://gallery.shinyapps.io/LDAelife/ --- class: inverse, center, middle # Workshop 6 : décryptons quelques algorithmes --- ## Décryptons quelques algorithmes - choisissez un cas d'usage - quelles données utilisées ? - connait-on l'algorithme utilisé ? - que fait l'algorithme des données ? - est-on capable d'expliquer les décisions prises par l'algorithme ? - quels biais et limites l'algorithme présente-t-il ? - où est la valeur ? Dans l'algorithme ou dans les données ? - qui crée cette valeur ? - etc. --- ## Décryptons quelques algorithmes Le cas d'APB, [décrypté par Cédric Villani](http://www.lemonde.fr/idees/article/2017/12/06/cedric-villani-ce-qui-a-bugge-dans-apb-ce-n-est-pas-le-logiciel-mais-bien-l-etat_5225204_3232.html) --- class: inverse, center, middle # Merci ! ## Évaluation de la journée