Carnet de bord de l’ouverture des données de Béthune

par Marion Caillaud, Diane O., Manon Crouzet, Téva Ledeux, Amaïa Masson et Jade Penancier

JOUR 1 – DIAGNOSTIC

Pour cette semaine de Challenge Data, nous accompagnons la collectivité de Béthune. Béthune est une commune d’environ 25 000 habitants dans le département du Pas-de-Calais (62).

Suite à la réunion d’introduction du Challenge, nous sommes allées gaiement rejoindre la table autour de laquelle nous allions passé tout ce challenge. Notre première mission a été de prendre contact avec notre référent de la collectivité, par ailleurs directeur du système d’information, afin de planifier un rendez-vous de 15h30 à 17h. Cette première après-midi a donc été consacrée au diagnostic Open Data de Béthune aux côtés de de notre référent et de la responsable RGPD de la collectivité.

Pour débuter l’entretien, nous avons fait le point sur les réflexions et démarches déjà menées par Béthune. Le questionnaire « Data Position Collectivités » a évalué un palier 3 concernant le niveau de maturité Open Data de Béthune, ce qui correspond à un niveau plutôt avancé.

Concernant les motivations de la collectivité à ouvrir ses données, il y en a plusieurs :

Tout d’abord, il y a le motif de l’obligation puisque la loi pour une République numérique du 7 octobre 2016 stipule l’obligation « d’open data par défaut » pour les collectivités locales de plus de 3500 habitants incluant donc celle de Béthune.

Ensuite, il y a la démarche de la Smart City dans laquelle est engagée Béthune depuis 2016.

Enfin, il y a le motif de l’attractivité. L’Open Data peut être un moyen de montrer ses atouts afin de tirer son épingle du jeu et attirer de nouvelles populations. D’autant plus que la taille de Béthune et sa proximité avec de grandes agglomérations telles que Lille constituent des avantages.

Néanmoins, malgré ces différentes motivations, il existe des freins dont le principal est le manque de culture et de compétences en interne sur le sujet.

Nous avons ensuite échangé autour des jeux de données que Béthune souhaitait ouvrir en parcourant le catalogue avec notre référent qui avait déjà au préalable identifié deux besoins au niveau des thématiques du commerce et de l’énergie. Ainsi, nous avons pu sélectionner deux jeux de données qui semblaient répondre à ces besoins : « Base commerce » et « Éclairage public ».

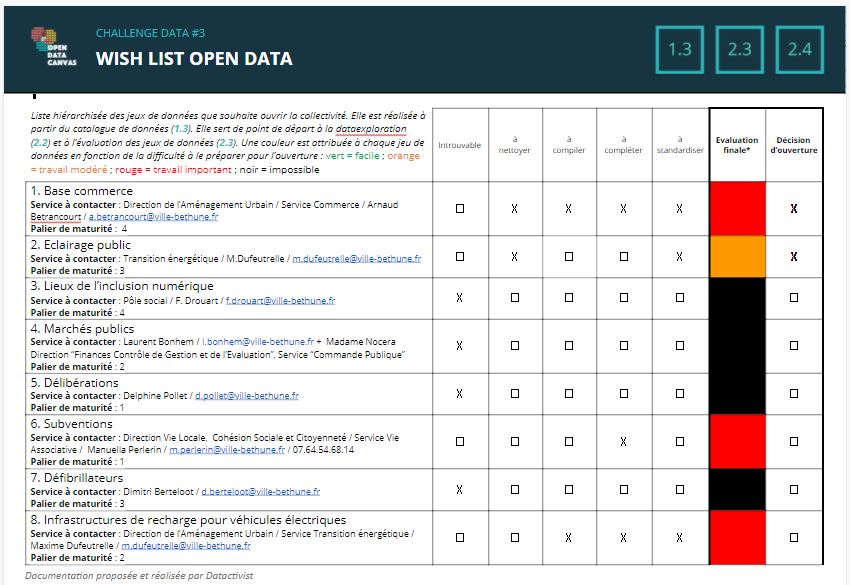

Pour le reste, nous avons parcouru le catalogue par thématique afin d’identifier de nouveaux jeux de données qui pourraient les intéresser et avons établi une wishlist de 8 jeux de données.

Cette première journée de Challenge s’est globalement très bien déroulée. Notre préparation de l’entretien en amont a rendu celui-ci plus fluide et le fait que la collectivité ait déjà réfléchi au sujet des jeux de données qu’elle souhaitait ouvrir a facilité l’étape d’identification des besoins.

Ci-dessous, la wishlist constitue l’aboutissement de cette première journée de Challenge que nous entamons dans la joie et la bonne humeur.

Lien wishlist : https://docs.google.com/document/d/1O8OEKXmWw9Ab2Tnbs8WHK26pZdZb0Bsd/edit

JOUR 2 – IDENTIFICATION

Rechercher les données

Nous avons commencé la journée de manière très active puisque notre référent nous avait dûment transmis la liste des personnes à contacter pour chaque jeu de données établi dans la wishlist la veille, nous n’avons donc pas eu à attendre cette liste de coordonnées. Nous nous sommes répartis chacune une personne à contacter par jeu de données et avons toutes envoyé nos mails, nous avons réfléchi à un modèle de mail pour que l’on envoie toute la même chose.

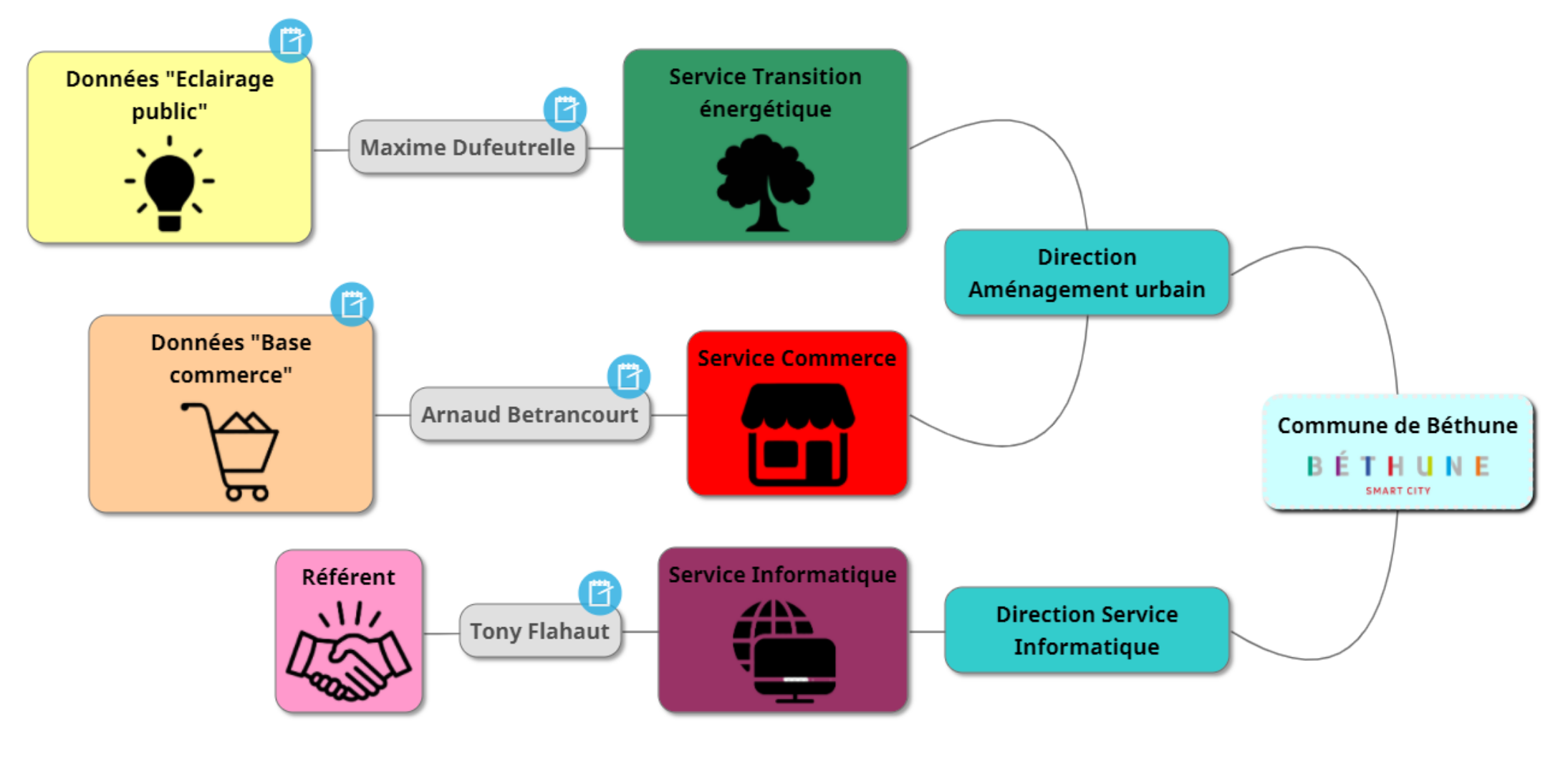

Compléter l’organigramme des données de la collectivité

En attendant la réponse de ces messages, nous avons établi l’organigramme des données, puisque notre référent nous avait donné des contacts précis en indiquant le service voire parfois aussi la direction, il a été assez facile de composer l’organigramme. Nous avons donc continué de le compléter avec les informations que nous donnaient les personnes contactées par mail (comme la direction rarement indiquée). Nous avons préféré compléter l’organigramme en amont, même si, au final, nous n’avons traité que deux jeux de données, donc l’organigramme est finalement beaucoup plus réduit. C’était une manière de s’organiser et de visualiser toutes les personnes à contacter, celles qui avaient répondu (où les informations étaient complètes), celles qui ne répondaient pas (où il était donc impossible de compléter soit la direction, soit le service, soit les deux).

Réponses des emails et début du travail

Les réponses pour récupérer les données pour chacun des jeux ont été de deux types : soit les interlocuteurs ont été très rapides et nous avons récupéré les données dans la matinée, soit les interlocuteurs nous ont redirigés plusieurs fois, ne semblaient pas savoir de quoi on parlait, etc… Nous avons surtout reçu des informations pour les jeux “base commerce” et “éclairage public”, et nous avons réalisé la quantité de données transmises. Nous avons donc essayé de comprendre, à plusieurs, comment fonctionnaient leurs jeux de données. Nous avons, cependant, rencontré des difficultés avec les données “base commerce” car celles-ci contenaient des données personnelles donc nous avons dû faire un gros nettoyage, étant donné que les données étaient conséquentes. Cependant, du fait que ce soit les premières données reçues (11h30), nous avons pu être efficaces sur ce tri. Concernant le jeu de données “éclairage public”, malgré le nombre de lignes conséquentes (4370 lignes sur Excel) qui nous a fait très peur au début, le fichier était plutôt clair et déjà dans une forme très proche de l’exemple proposé sur Workbench.

Des fichiers très parcellaires et de longs moments d’attente

En fait, malgré la réussite finale de la journée, nous avons récupéré et décidé de travailler sur deux jeux de données très intéressants et ceux que la commune voulait le plus. Aux environs de 15/16h jusqu’à la fin de la journée, nous avions réalisé la plupart du travail demandé pour la journée (à savoir : nous avions évalué les jeux des données reçus et nous avions réalisé l’organigramme). Donc, nous avons surtout passé beaucoup de temps à attendre des réponses de certains interlocuteurs. Heureusement notre référent s’est montré très réactif et nous a aidé à nous rediriger vers d’autres personnes quand cela était nécessaire.

Les autres données reçues se sont avérées décevantes. Que ce soit pour les “emplacements pour recharge électrique” où les données étaient peu satisfaisantes vis à vis de l’exemple présenté dans le Workbench. Ou alors, le cas des données “subventions” où il semble qu’il y ait eu un manque de communication en interne puisqu’il y a eu des difficultés sur les données personnelles : la personne contactée ne savait pas quelles données elle était autorisée à nous fournir ou non.

Un autre problème fut celui des données “marchés publics” où la personne ne comprenait pas quelles données elle devait nous communiquer, ni sous quelle forme. On s’est rendu compte que ce ne serait finalement pas possible de les récupérer. Ce fut également le cas pour les “délibérations” où les interlocuteurs ont changé plusieurs fois et où on ne savait pas comment exporter les données. Les agents ont l’air d’utiliser plusieurs progiciels et ne savent pas comment exporter les données depuis ces logiciels vers des formats Excel.

Enfin, sur le jeu de données “inclusion numérique”. Nous n’avons tout simplement pas eu de retour. Après en avoir discuté avec notre référent, il semblerait que plusieurs de nos interlocuteurs avaient un emploi du temps très chargé.

Tous ces petits problèmes nous confirment aussi le manque de formation à ce sujet dans la commune, comme nous le disait notre référent à la réunion de la veille. Les agents de la commune ne sont pas familiers d’un discours autour de l’open data, ne savent pas comment fonctionner en Excel, etc. Malgré cette petite frustration, nous étions très satisfaites (et fatiguées) en finissant la journée, car nous avions récupéré les jeux de données les plus intéressants et les plus fournis et surtout, les jeux de données qui les intéressaient le plus !

Evaluer les jeux de données et s’engager sur une wanted data list

Notre travail d’évaluation et de wanted data list fut plutôt rapide puisque nous avons eu deux “gros et beaux fichiers” sur “base commerce” et “éclairage public”, et que le reste ne fut pas très concluant. Nous avons donc décidé de nous concentrer sur ces deux-là, et en sommes ravis puisque c’est ce que notre référent nous avait indiqué comme priorité.

Nous lui avons bien sûr envoyé un mail afin de lui faire un débrief de ce que nous avions fait aujourd’hui et nous lui avons transmis notre souhait de s’engager à l’ouverture de deux jeux : “base commerce” et “éclairage public”. Maintenant, plus qu’une seule hâte : commencer à plonger le nez (et toute la tête) dans les jeux de données afin de les rendre tout beaux, tout propres !

JOUR 3 – MISE EN QUALITÉ

Utilisation de workbench

Nous avons mis du temps avant de bien comprendre les différentes fonctionnalités de workbench. Nous avons parfois été tentées d’exporter le fichier pour le modifier sur Excel, mais nous aurions perdu la trace des différentes étapes successives. L’outil Workbench est en fait assez pratique une fois que l’on comprend son fonctionnement.

Jeu de données “Eclairage public”

Le jeu de données sur l’éclairage public a été assez facile à nettoyer. Nous avons simplement supprimé des colonnes vides, incomplètes ou qui donnaient des informations dont nous n’avions pas besoin. Nous avons aussi ajouté la colonne code postal. La standardisation des données s’est aussi faite assez rapidement, bien que nous ayons eu des difficultés pour formater nos chiffres. Pour les dates, nous avons donné un jour précis, mais en posant l’hypothèse que le jour correspond à une période d’un mois.

Validation : aucun validateur n’existe pour les jeux d’éclairage public. Nous avons donc dû valider manuellement. Nous avons donc vérifié les lignes 80, 158, 1941, 2946, 4094. On a eu une hésitation avec la ligne 158, qui indique des valeurs négatives pour la consommation, l’émission de CO2 et le coût.

Jeu de données base commerce

Le jeu de données sur la base commerce a été bien plus long et compliqué à nettoyer et standardiser.

Géolocalisation : les données sur les adresses des commerces étaient données sous format “n° de voie, voie” et il a fallu les modifier par rapport au standard de l’exemple (points de géolocalisation). Après avoir testé le site Geocode, nous n’avons pas eu de résultats concluants. Arthur (Datactivist) nous a donc aidé avec un outil plus performant (Open data soft) et nous avons récupéré les données nécessaires.

Nous avons d’abord commencé le traitement des données en supprimant les colonnes/lignes vides et celles où les informations manquaient trop pour les exploiter.

Pour les catégories de commerces, il a fallu simplifier leur qualification en renommant les catégories et en fusionnant certaines. Pour ce faire, nous avons suivi une méthodologie sur workbench : Refine + categorie_fr + chercher toutes les catégories en rapport avec la nouvelle catégorie à créer + merge + renommer.

Nous avons aussi dû rajouter de nombreuses informations dans le fichier base commerce : code epci, nom de l’epci, numéro de région, nom de la région, du département. Il est compliqué de créer des colonnes sur Workbench. Il faut dupliquer une colonne existante éditée en texte et la formater en nombre pour faire disparaître le texte et pouvoir remplir automatiquement ensuite. Quand enfin nous avons fait ça, la fonction “fill null cells” est pratique.

Nous n’avons pas d’information sur les horaires d’ouverture.

Drame : des colonnes ont disparu ! L’adrénaline est montée mais nous nous sommes vite aperçues de notre erreur : c’est qu’il faut bien sélectionner la dernière étape pour voir le document dans son état actuel.

Pour les commerces manquants, nous avons créé un document excel en y indiquant les informations. Nous avons des difficultés à joindre les deux fichiers.

Validation : même technique que pour l’autre jeu de données : lignes 25, 419, 333, 115, 24 : pas de problème.

JOUR 4 – PUBLICATION

Dès le début de la journée, la première chose que nous avons faite a été d’envoyer un mail à notre référent afin de lui demander une réunion pour valider nos jeux de données à ouvrir et lui poser des questions sur le plan de communication. Nous avons également envoyé un mail au responsable de la base commerce et de la base éclairage public afin d’avoir plus d’informations pour remplir la fiche descriptive. Nous leur avons posé des questions présentes sur la fiche et nous leur avons dit qu’ils pouvaient nous appeler si toutefois ils avaient des questions.

Concernant nos jeux de données, nous essayons d’ajouter la colonne “Horaires” bien que nous n’en ayons aucun de renseigné. Elle reste utile si toutefois la commune de Béthune souhaite les rajouter par la suite. Cependant, nous avons du mal à ajouter une colonne. De nombreuses données ont disparu ! Nous avons dû faire un retour en arrière pour retrouver nos données. Il est très compliqué de travailler à plusieurs sur WorkBench, nous avons donc choisi que l’une d’entre nous partage son écran, qu’on discute de ce qu’il faut faire mais qu’ elle seule manipule le WorkBench.

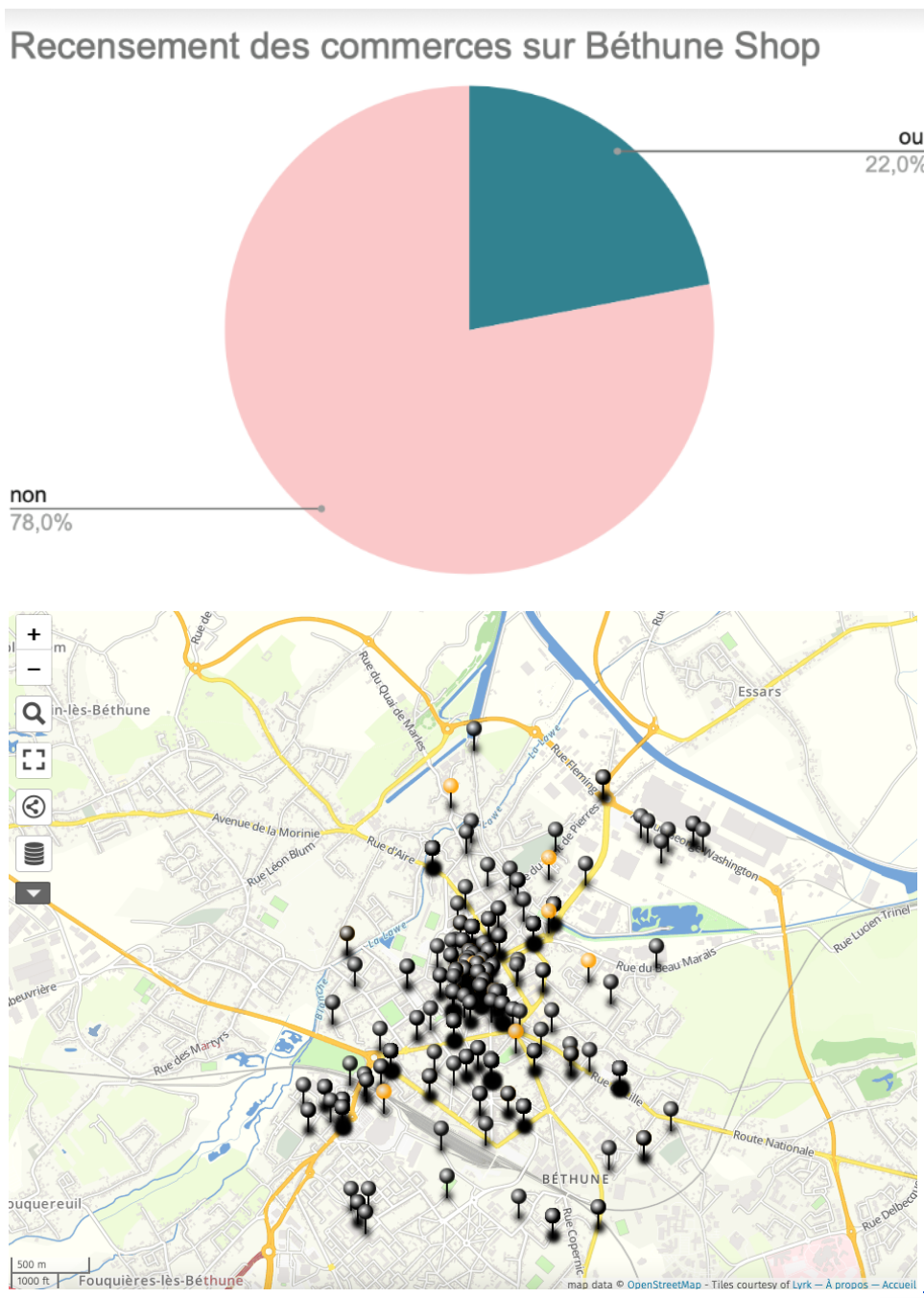

Nous avons rajouté une colonne optionnelle dans ce jeu de données, la colonne “Béthune Shop” qui permet de recenser les commerces qui font partie de cette application. Pour ce faire, nous avons fait cela à la main en créant une colonne et en remplissant la colonne non automatiquement. Puis, au fur et à mesure, nous avons remplacé les “non” par des “oui” lorsque les commerces faisaient partie du Marketplace Local (Bethune Shop).

Nous avons eu une réunion avec notre référent pour lui montrer nos jeux de données, il en était d’ailleurs très content. Il y voit un grand intérêt notamment pour le recensement des commerces. Cependant, il trouvait cela dommage que le référent des éclairages publics ne nous ait pas communiqué des données après décembre 2019 et pas jusqu’à fin 2020 sachant que dans certains quartiers, les éclairages sont passés aux leds et il aurait été intéressant de comparer la consommation.

Nous lui avons demandé quelle licence nous devions utiliser entre la licence ouverte ou la licence odbl qui est une licence dite “contaminante”. Ce n’est pas le cas, pour nos jeux de données, a priori nous partirons sur la licence ouverte.

Nous lui posons ensuite des questions sur le plan de communication. Bethune ayant déjà un compte sur data.gouv, nous avons pu récupérer l’identifiant afin de publier les données cet après-midi. Il va également nous donner les coordonnées du service communication.

Nos deux interlocuteurs pour nos deux bases de données (commerces et éclairages publics) ont répondu à nos mails concernant les questions de la fiche descriptive. Nous les avons donc remplis grâce aux réponses données.

Après la pause déjeuner, nous nous sommes attelées à la publication des jeux de données. Béthune avait déjà un compte sur data gouv avec 11 jeux de données ouverts. Nous avons commencé par l’éclairage public puis par la base commerce. Nous ne savions pas réellement quoi mettre dans la description. Nous y avons réfléchi ensemble afin de faire une description du jeu de données la plus complète possible. La publication a été faite rapidement, le site data.gouv.fr est intuitif et très simple d’utilisation.

Nous avons réussi à joindre par téléphone le responsable du service de communication de la ville qui n’avait pas connaissance du Challenge mais qui a été très content lorsque nous lui avons expliqué. Il souhaiterait le communiquer sur le site internet, partager l’article du site sur facebook ainsi que le publier dans le journal de la ville de Béthune.

Nous avons terminé l’organigramme en mettant les liens des jeux de données.

Pour terminer cette journée, nous avons envoyé un mail au responsable communication en lui envoyant notre plan de communication afin qu’il le complète si besoin et nous avons envoyé un mail récapitulatif à notre référent avec les liens des jeux de données publiés sur data gouv.

Url pour le jeu éclairage public : https://www.data.gouv.fr/fr/datasets/eclairage-public-de-la-ville-de-bethune-2017-2019-1/

Url pour le jeu base commerce : https://www.data.gouv.fr/fr/datasets/commerces-de-la-ville-de-bethune/

JOUR 5 – VALORISATION

Datavisualisations avec uMap :

-

Plusieurs difficultés : nécessité de modifier la colonne géolocalisation en séparant la colonne en deux (latitude et longitude) pour que uMap reconnaisse la géolocalisation des éléments.

Certaines adresses étaient mal géolocalisées car nom de voie mal retranscrit de la part de la collectivité (Grand’Place au lieu de Grand Place).

-

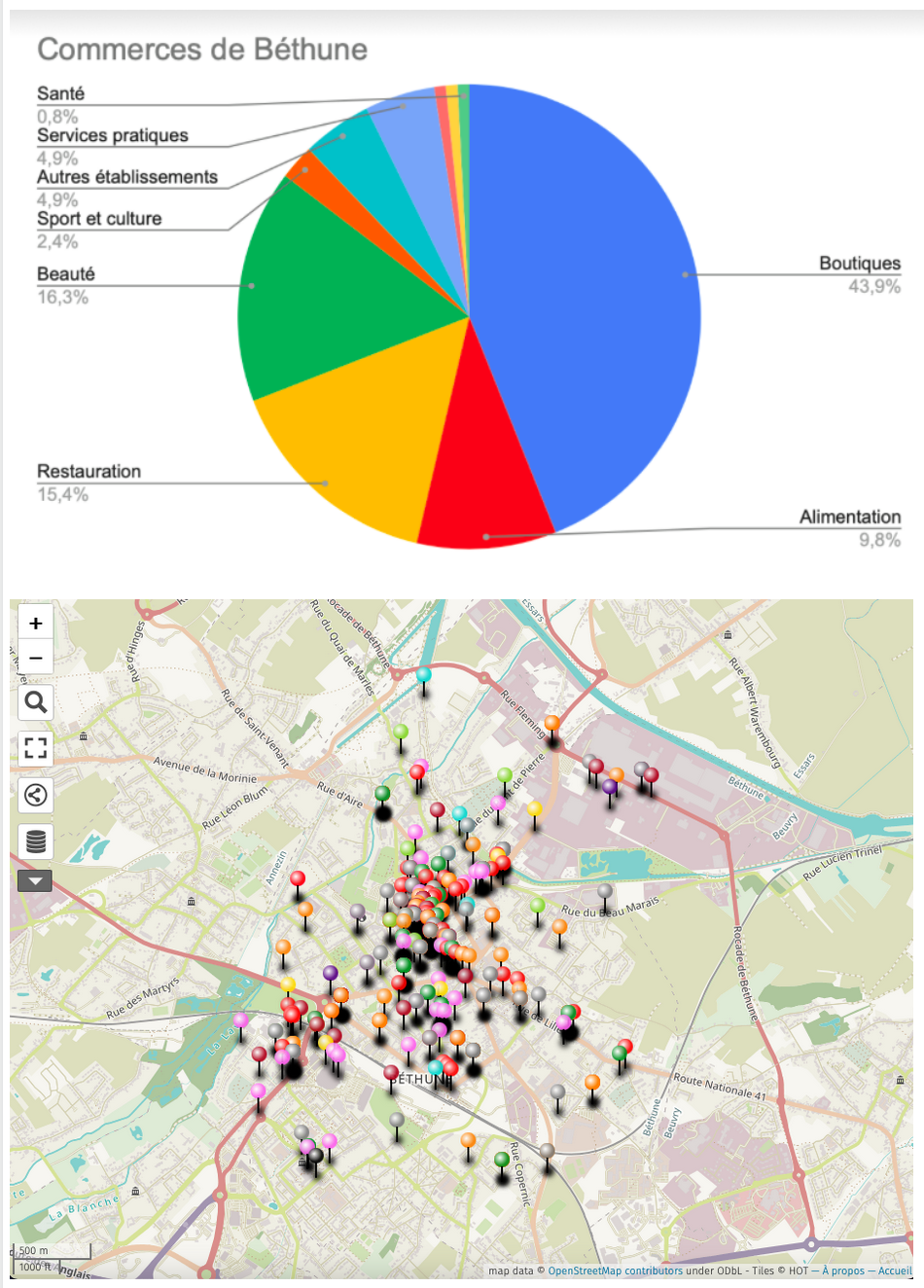

Modification : Création de deux catégories supplémentaires (Beauté et Sport et culture) pour rendre les datavisualisations par secteur plus intéressantes.

Nous avons débuté la journée en modifiant les publications de données sur Datagouv avec le nom du challenge ainsi que Datactivist et l’ANCT dans la description.

Après avoir réfléchi aux usages que les collectivités pourront faire des ces visualisations, nous avons convenu que :

- Pour la base commerces,

Nous ferons deux maps (une pour visualiser la répartition des commerces par secteur d’activité dans la commune et une pour visualiser la répartition géographique des commerces présents sur l’application Béthune shop) ainsi que deux diagramme circulaires afin d’observer la proportion de commerces par secteur d’activité et par la présence ou non sur l’application Béthune shop

- Pour la base éclairages publics,

Nous avons donc réalisé les deux maps de la base commerce sur Umap en utilisant plusieurs calques. Le graphique a été réalisé sur Rawgraph. Nous avons rencontré quelques difficultés sur les deux sites notamment sur les formats des données et la compréhension du site Rawgraph.

Eclairage public :

Difficultés : on a de grosses difficultés à travailler sur le jeu de données d’une part parce qu’il est très conséquent (4300 lignes de données) et donc les logiciels utilisés rament beaucoup et ne parviennent pas à afficher toutes les données sur un seul graphique; d’autre part, car le jeu de données a beaucoup d’informations différentes à présenter (localisation, date, consommation, coût, émission) : donc c’est très difficile de savoir comment organiser le graphique autour de toutes ces idées.

On a abandonné l’idée d’inclure la localisation dans la visualisation parce que c’est trop compliqué. On va donc essayer de faire une moyenne des données de toutes les localisations sur 1 mois afin de faciliter et de rendre plus compréhensible le graphique.

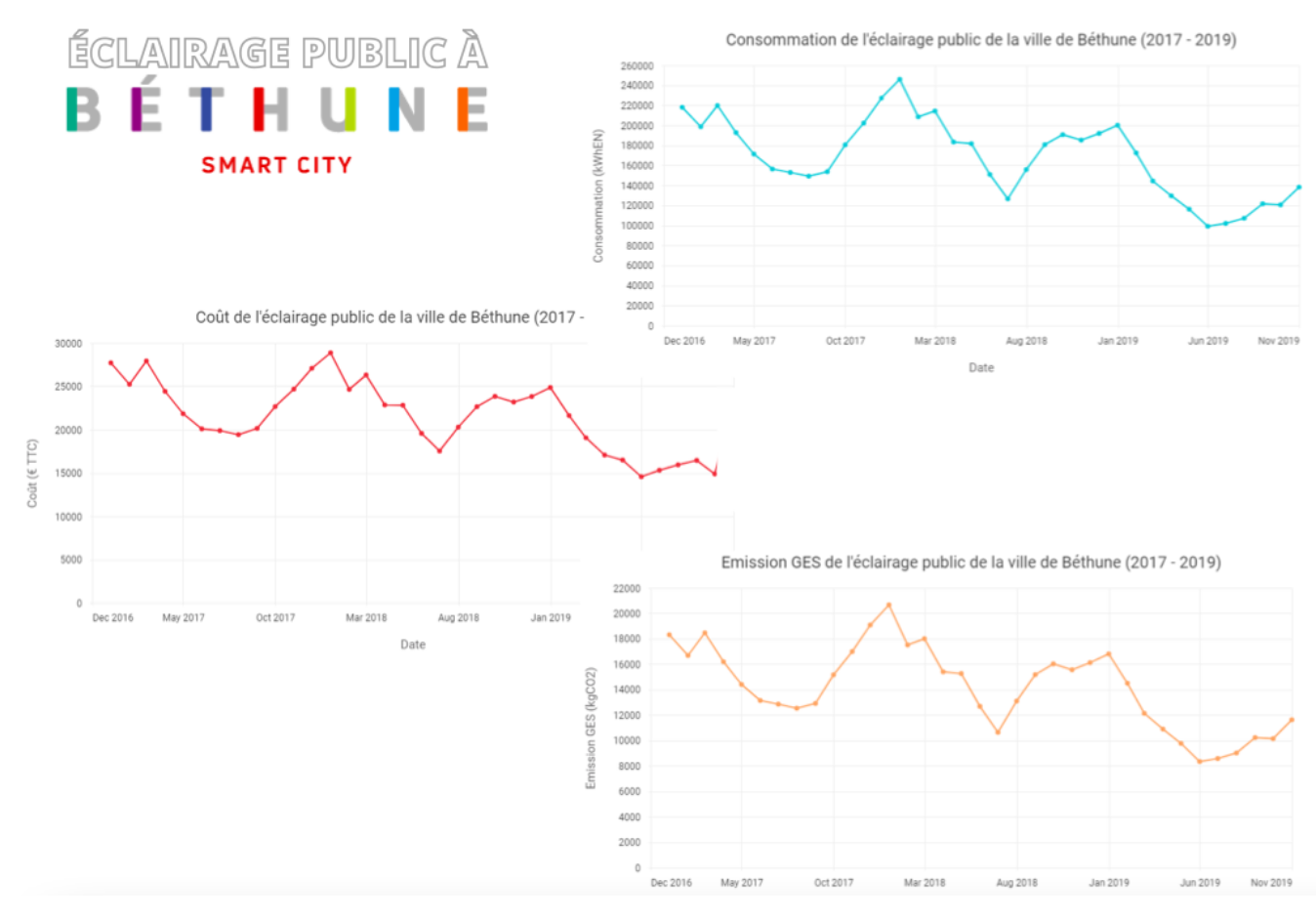

Guillaume nous a aidé à effectuer les graphiques sur Workbench : on a donc un graphique pour les émissions, un pour les consommations et un pour les coûts.

Commerces :

Pas de réelles difficultés pour la datavisualisation de la base commerces mais les visualisations cartographiées avec Umap ont pris beaucoup de temps à réaliser.

Après avoir réalisé les visualisations (7 au total), nous avons complété les fiches descriptives des fichiers et publié ces fiches et les datavisualisations sur le site datagouv pour les deux jeux de données.

Marion a également réalisé une infographie qui permet de réunir les différentes informations pour la base commerces afin de permettre aux communicants d’informer sur cette ouverture de données.

Explications des datavisualisations) et dernières publications puis réunion finale et discussions avec notre référent, les étudiants et tous les acteurs ayant participé à cette semaine.

Nous avons fini par envoyer un mail à tous nos référents avec le récapitulatif de la semaine et les visualisations terminées.

Base commerces :

http://umap.openstreetmap.fr/fr/map/recensement

Base éclairage public :

CONCLUSION

Bilan de la commune :

Ce challenge a permis à la commune de Béthune d’ouvrir deux jeux de données : la base commerce et l’éclairage public.

Notre travail a été facilité par la bonne maturité open data de la commune de Béthune puisque la ville avait déjà publié onze jeux de données sur la plateforme data.gouv. Cependant, nous n’avons pu ouvrir que deux jeux de données sur les huit que nous avions répertoriés dans la wishlist de la commune. La collecte d’autres jeux de données a été freinée par l’absence de données exploitables ou exportables au format xls ou csv (c’était par exemple le cas pour les données des délibérations). Nous étions aussi contraints par le temps. En bref, nous n’avions que deux ensembles de données exploitables sur huit… mais la qualité prime sur la qualité, non ?

Dans l’ensemble, notre contact référent, s’est montré satisfait de notre travail et enthousiaste à l’idée d’ouvrir les données de la ville. En ouvrant ces deux jeux de données, nous avons contribué à la maturité open data de la commune de Béthune qui a pour ambition de devenir une smart city. Les visualisations du jeu de donné de l’éclairage public a pu mettre en valeur les économies d’énergie effectuées grâce à la conversion à l’éclairage LED, tandis que la visualisation des commerces permet de voir les enseignes présentes sur l’application locale Béthune-Shop.

Bilan de l’équipe :

Nous avons instauré un flux de travail assez efficace. Nous avions pour routine de nous répartir les tâches durant la matinée après avoir regardé les tutoriels de la journée. Ensuite, nous nous divisions en groupes de trois pour travailler sur les tâches importantes comme la mise en qualité des données. Mais notre rythme de travail était souvent freiné par les temps d’attente et les problèmes techniques.

L’étape la plus difficile était la mise en qualité des jeux de données, surtout pour celui de la base commerce car les données n’étaient pas standardisées. Par exemple, le jeu comprenait seulement des adresses au format qu’il nous a fallu convertir en codes de géolocalisation. La plus grande difficulté était toutefois de compiler les deux jeux de données que nous avions, puisque certains commerces ne figuraient pas dans la base de données principale. En revanche, le nettoyage et la complétion du jeu sur l’éclairage public.

Et pour la visualisation, le problème s’est inversé. En effet, l’éclairage public était bien plus difficile à visualiser, puisque le document comportait environ 4300 lignes (!) qui ont mis KO les outils de visualisation Rawgraph et Datawrapper. Par contre, les commerces étaient beaucoup plus faciles à cartographier et à trier en catégories.

Le challenge data porte bien son nom, puisque nous avons vu la difficulté des tâches augmenter à mesure que la semaine avançait.

Notre semaine de travail en chiffres :

2 jeux de données nettoyés, ouverts

7 datavisualisations (4 pour la base commerce et 3 pour l’éclairage)

2 réunions avec nos interlocuteurs de la ville de Béthune

La découverte de 5 plateformes de travail (Airtable, Workbench, Umap, Rawgraph et GatherTown)

Une 50aine de mails échangés avec les agents de la mairie de Béthune

8 services contactés lors de la collection des données

… et une 15aine d’onglets de travail ouverts sur nos écrans tous les jours

Note plus belle réussite : Notre visuel de la base commerce de la ville

Notre plus grande difficulté: Nettoyer la base commerce sur l’outil Workbench qui a beaucoup fatigué nos yeux et nos ordinateurs

Notre travail en mots, avec un word cloud des mots les plus utilisés dans notre carnet de bord :

Tableau récapitulatifs des bilans individuels :

| Ce que vous avez appris durant cette semaine | La plus grosse difficulté + belle réussite | Le challenge en un mot pour vous | |

|---|---|---|---|

| Amaïa | Première immersion dans le domaine des données pour une étudiante très peu qualifiée (voire pas du tout) en informatique et dans ces questions de traitement. J’ai appris à analyser un jeu de données, le nettoyer et tenter d’utiliser au mieux Workbench ! | Difficultés importantes avec l’outil Workbench. Difficultés à cause de mon manque sérieux de connaissances dans les outils tels qu’Excel mais aussi les compétences de base en informatique. | Fédérateur |

| Diane | Découverte de l’utilité de l’ouverture de données publiques - ce qui semble très abstrait quand on n’en a jamais vraiment entendu parler. J’ai également appris à utiliser beaucoup mieux Excel et j’ai découvert plein de logiciels que je connaissais pas du tout comme Open Street Map et Workbench, entre autres. | Difficultés à appréhender l’outil Workbench mais c’était amusant aussi de devoir rechercher comment l’utiliser en manipulant différentes fonctionnalités. Difficultés aussi pour la visualisation avec le jeu de données sur l’éclairage public - il y avait beaucoup d’informations à mettre en avant. La réussite c’était vraiment le résultat final, de voir ce qu’on avait accompli en 5 jours en visualisation. | Fédérateur |

| Jade | Impression d’avoir appris un métier en 5 jours. Beaucoup de plateformes et de connaissances sur l’open data apprises en très peu de temps. | Difficulté : toutes les difficultés techniques (workbench, dataviz), la fatigue à partir du 3ème jour, la mise en qualité chronophage Réussite : travail d’équipe et des résultats concrets. | Intense |

| Manon | Je n’aurais jamais cru pouvoir faire autant de choses à partir d’une liste de données. Le Challenge Data m’a fait réaliser que travailler sur des données n’était pas le travail impossible que je m’imaginais. | La plus grosse difficulté : la visualisation, surtout quand on a une connexion qui ne supporte pas le poids de gather et des différentes plateformes. Réussite : arriver au bout de cette semaine en un seul morceau ! | Intense |

| Marion | J’ai réellement découvert un nouvel univers avec l’Open Data. J’ai appris que ce domaine nécessite à la fois de la rigueur et de la patience qui méritent d’être enseignées afin de tendre vers plus de transparence. | L’étape de la data visualisation a été à la fois la plus grosse difficulté et la plus grosse réussite. Les étapes ont été bien plus longues que prévues mais le résultat fut à la hauteur ! | Coopération |

| Téva | Pleins de choses ! Globalement le traitement de données, le fonctionnement du Workbench, Umap | Nettoyer, compiler et standardiser la base commerce + nos visuels | Convivial |